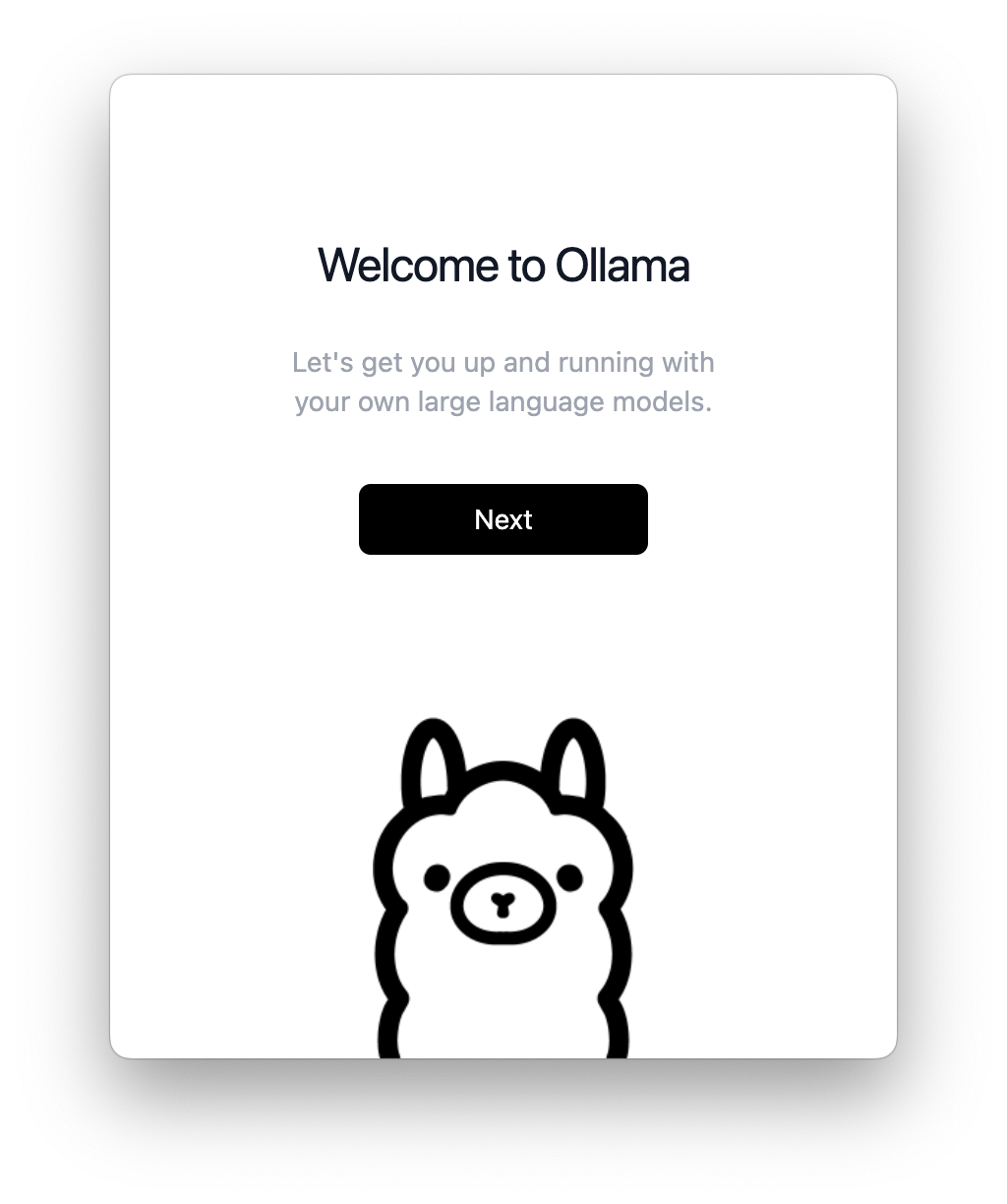

Для начала переходим по ссылке и устанавливаем приложение которое весит 182 Мб. Распаковываем архив и загружаем его. После этого добавляем алиас ollama прокликивая далее в интерфейсе. Когда закончите, устанавливаете 7B model (весит около 3.8 Гб):

ollama pull llama2Если скачивание прервалось (unexpected end to pull model), попробуйте повторить этой же командой.

Вы также можете установить 13B model (весит около 7.3 Гб), но учтите, что для запуска потребуется более 9 Гб VRAM:

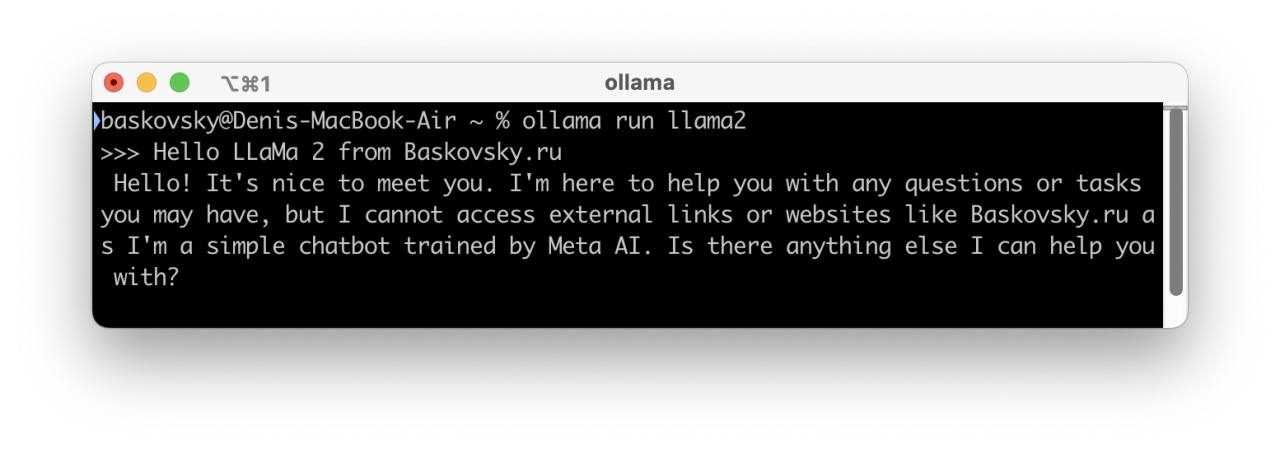

ollama pull llama2:13bПосле завершения установки, перезагружаем терминал и можем можно включать ollama. Для запуска чат-бота воспользуйтесь следующей командой::

ollama run llama2

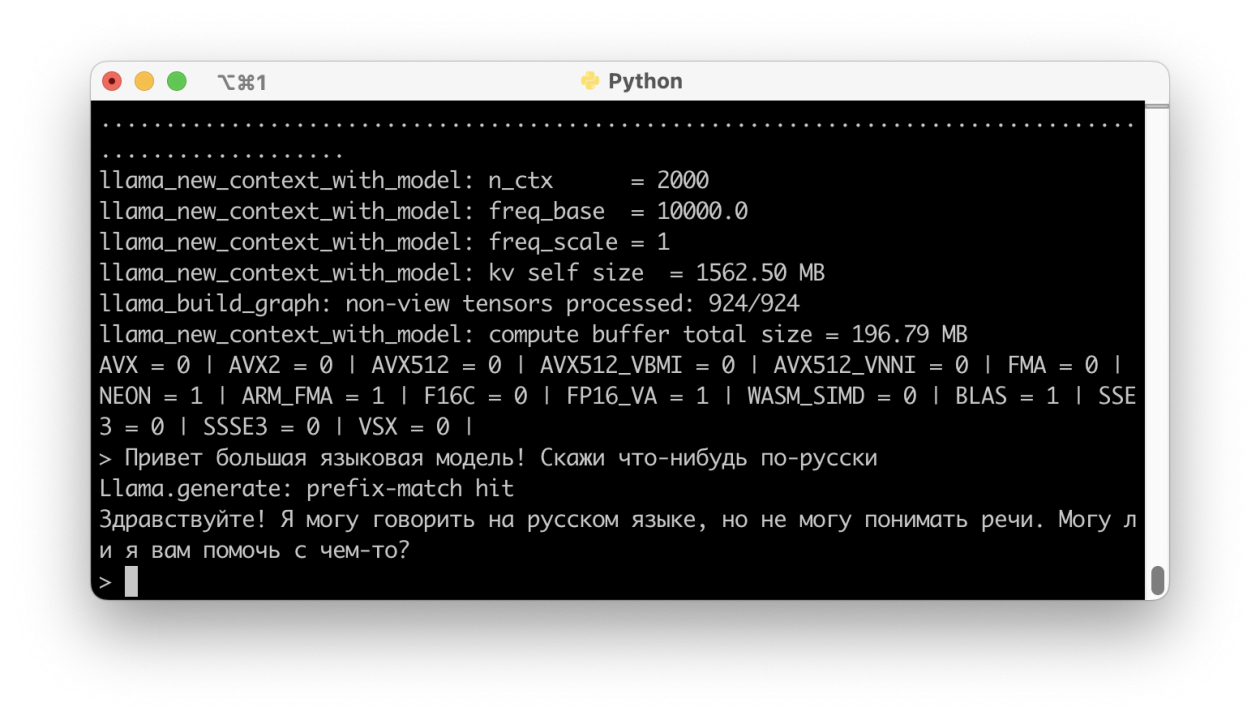

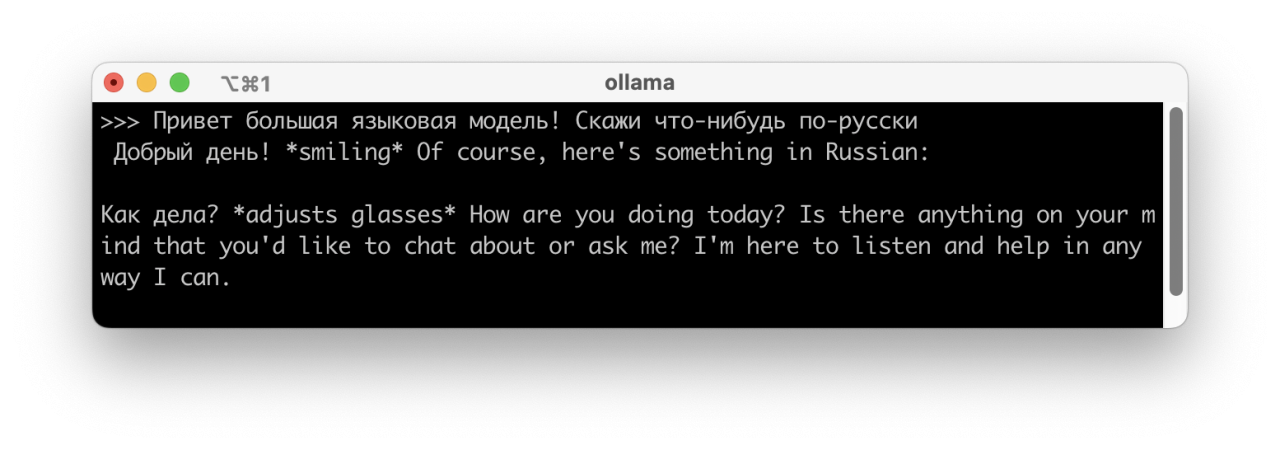

На моем Macbook Air 2020 работает достаточно шустро. Далее вы можете настроить самостоятельно модели через CLI ollama. Для версии 0.0.16 доступны следующие команды:

- serve — запустить экземпляр ollama

- create — создать модель из Modelfile

- run — начать диалог

- pull — спулить модель из реестра

- push — запушить модель в реестр

- list — отобразить список моделей

- cp — скопировать модель

- rm — удалить модель